ELK Stack插件——Analyze中文分词

一、什么是分词

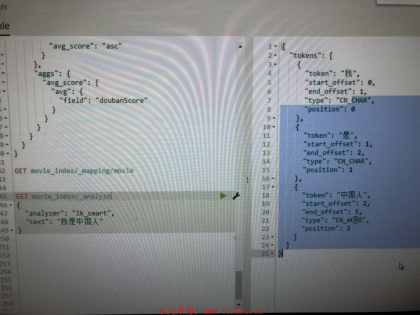

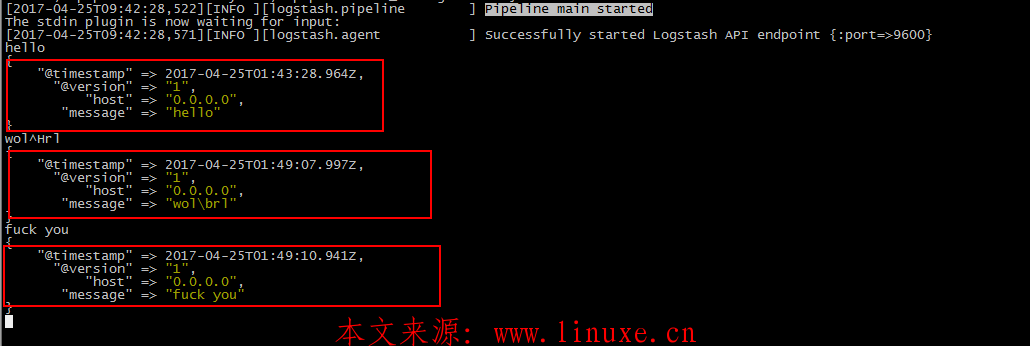

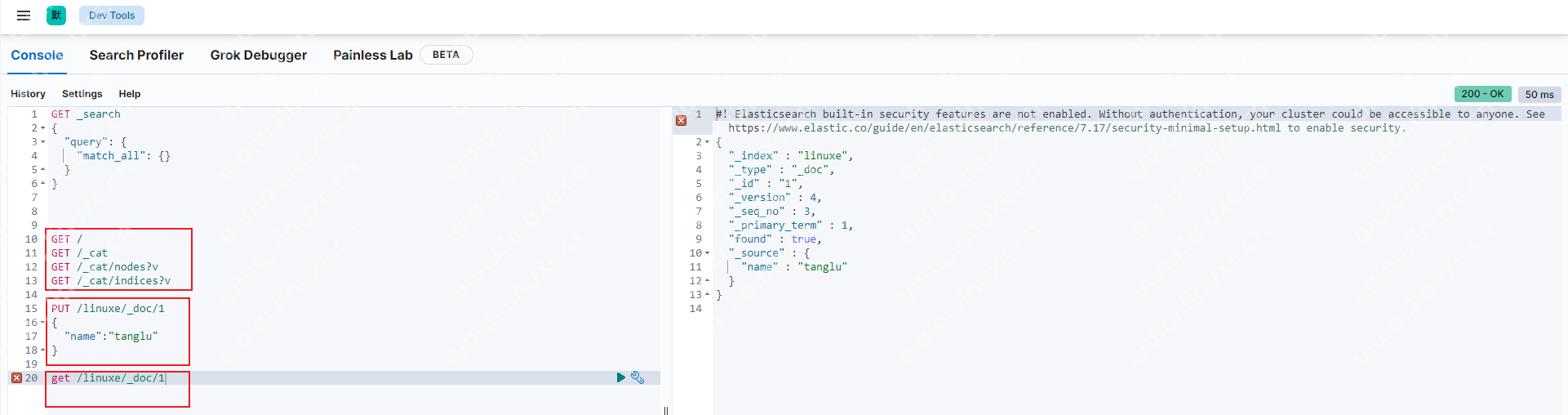

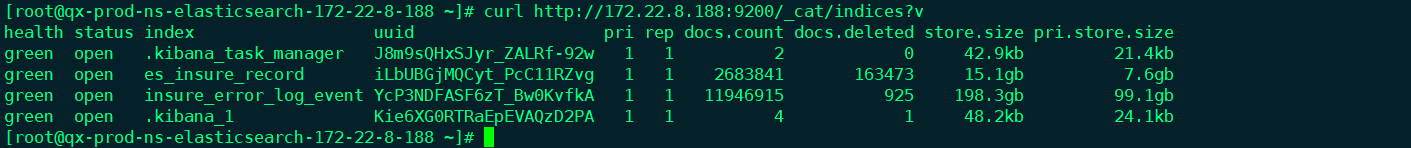

Elasticsearch的Analysis功能叫做分词,是把全文本转换成一系列单词的过程。Elasticsearch本身有很多的分词API,如standard(按单词切分)、simple、whitespace(按空格切分)、pattern(正则分词)等等,如图:

二、Elasticsearch的中文分词

由于外国人对于汉字的不了解,没有词汇的概念,只是单纯的逐个拆分每句话中的每个字。为了更好的进行中文分词,需要使用专门的中文分词插件elasticsearch-analysis-ik,简称IK。

1、下载IK分词器,下载地址是https://github.com/medcl/elasticsearch-analysis-ik

2、将下载好的包解压并放到elasticsearch/plugins目录下

3、重启Elasticsearch服务

4、查询数据进行测试,可以看到图中将analyzer指定为了ik_smart,除此还可以使用最大化分词ik_max_smart,后者可以尽可能的多去进行分词。具体用哪个看自己需要:

版权声明:本文章版权归数据库运维网(www.ywdba.cn)所有。如需引用本站内容,请注明来源及作者。

评论